Page 163 - CATALOGUE AGINIUS 2020

P. 163

IT - Big Data - Cybersécurité IT - Big Data - Cybersécurité

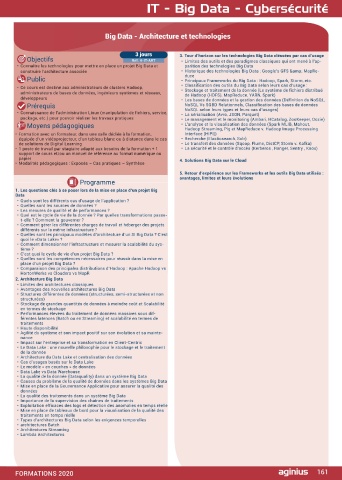

Big Data - Enjeux et opportunités Big Data - Architecture et technologies

2 jours 6. Protection des données 3 jours 3. Tour d’horizon sur les technologies Big Data cléssées par cas d’usage

Objectifs Ref. 4-IT-BDBA • La conservation dans le temps face aux accroissements de volumétrie. Objectifs Ref. 4-IT-ART • Limites des outils et des paradigmes classiques qui ont mené à l’ap-

• Découvrir les principaux concepts du Big Data • La sauvegarde, en ligne ou locale ? • Connaître les technologies pour mettre en place un projet Big Data et parition des technologies Big Data

• Identifier les enjeux économiques • L’archive traditionnelle et l’archive active. construire l’architecture associée • Historique des technologies Big Data : Google’s GFS & MapRe-

• Evaluer les avantages et les inconvénients du Big Data • Les liens avec la gestion de hiérarchie de stockage : avenir des bandes duce

• Comprendre les principaux problèmes et les solutions potentielles magnétiques. Public • Principaux Frameworks du Big Data : Hadoop, Spark, Storm, etc.

• Identifier les principales méthodes et champs d’application du Big Data • La réplication multisites. • Ce cours est destiné aux administrateurs de clusters Hadoop, • Classification des outils du Big Data selon leurs cas d’usage :

• La dégradation des supports de stockage.

Public 7. Méthodes de traitement et champs d’application administrateurs de bases de données, ingénieurs systèmes et réseaux, • Stockage et traitement de la donnée (Le système de fichiers distribué

de Hadoop (HDFS), MapReduce, YARN, Spark)

• DSI, directeurs techniques, chefs de projet, architectes, responsables SI • Classification des méthodes d’analyse selon le volume des données et développeurs • Les bases de données et la gestion des données (Définition du NoSQL,

la puissance des traitements. Prérequis NoSQL Vs SGBD Relationnels, Classification des bases de données

Prérequis • Hadoop : le modèle de traitement Map Reduce. • Connaissance de l’administration Linux (manipulation de fichiers, service, NoSQL selon leurs types et leurs cas d’usages)

• Connaissances de base des architectures techniques • L’écosystème Hadoop : Hive, Pig. Les difficultés d’Hadoop. package, etc.) pour pouvoir réaliser les travaux pratiques • La sérialisation (Avro, JSON, Parquet)

• Le management et le monitoring (Ambari, HCatalog, ZooKeeper, Oozie)

• OpenStack et le gestionnaire de données Ceph.

Moyens pédagogiques • Le Complex Event Processing : un exemple ? Storm. Moyens pédagogiques • L’analyse et la visualisation des données (Spark MLIB, Mahout,

Hadoop Streaming, Pig et MapReduce v. Hadoop Image Processing

• Du BI au Big Data.

• Formation avec un formateur, dans une salle dédiée à la formation, équipée • Le décisionnel et le transactionnel renouvelés : les bases de données • Formation avec un formateur, dans une salle dédiée à la formation, Interface (HIPI))

d’un vidéoprojecteur, d’un tableau blanc ou à distance dans le cas de solutions NoSQL.Typologie et exemples. équipée d’un vidéoprojecteur, d’un tableau blanc ou à distance dans le cas • Recherche (Elasticsearch, Solr)

de Digital Learning • L’ingestion de données et l’indexation. Deux exemples : splunk et de solutions de Digital Learning • Le transfert des données (Sqoop, Flume, DistCP, Storm v. Kafka)

• 1 poste de travail par stagiaire adapté aux besoins de la formation + 1 support Logstash. • 1 poste de travail par stagiaire adapté aux besoins de la formation + 1 • La sécurité et le contrôle d’accès (Kerberos , Ranger, Sentry , Knox)

de cours et/ou un manuel de référence au format numérique ou papier • Les crawlers Open Source. support de cours et/ou un manuel de référence au format numérique ou

• Modalités pédagogiques : Exposés – Cas pratiques – Synthèse • Recherche et analyse : Elasticsearch. papier 4. Solutions Big Data sur le Cloud

• L’apprentissage : Mahout. In-memory. • Modalités pédagogiques : Exposés – Cas pratiques – Synthèse

Programme • Visualisation : temps réel ou non, sur le Cloud (Bime), comparaison 5. Retour d’expérience sur les Frameworks et les outils Big Data utilisés :

QlikView, Tibco Spotfire, Tableau.

1. Introduction • Une architecture générale du data mining via le Big Data. Programme avantages, limites et leurs évolutions

• Les origines du Big Data : un monde de données numériques, l’e-santé, 8. Cas d’usage à travers des exemples et conclusion

chronologie. • L’anticipation : besoins des utilisateurs dans les entreprises, mainte- 1. Les questions clés à se poser lors de la mise en place d’un projet Big

• Une définition par les quatre V : la provenance des données. nance des équipements. Data

• Une rupture : changements de quantité, de qualité, d’habitudes. • La sécurité : des personnes, détection de fraude (postale, taxes), le • Quels sont les différents cas d’usage de l’application ?

• La valeur de la donnée : un changement d’importance. réseau. • Quelles sont les sources de données ?

• La donnée en tant que matière première. • La recommandation. Analyses marketing et analyses d’impact. • Les mesures de qualité et de performances ?

• Le quatrième paradigme de la découverte scientifique. • Analyses de parcours. Distribution de contenu vidéo. • Quel est le cycle de vie de la donnée ? Par quelles transformations passe-

2. Big Data : traitements depuis l’acquisition jusqu’au résultat • Big Data pour l’industrie automobile ? Pour l’industrie pétrolière ? t-elle ? Comment la gouverner ?

• L’enchaînement des opérations. L’acquisition. • Faut-il se lancer dans un projet Big Data ? • Comment gérer les différentes charges de travail et héberger des projets

• Le recueil des données : crawling, scraping. • Quel avenir pour les données ? différents sur la même infrastructure ?

• La gestion de flux événementiels (Complex Event Processing, CEP). • Gouvernance du stockage des données : rôle et recommandations, le • Quelles sont les principaux modèles d’architecture d’un SI Big Data ? C’est

• L’indexation du flux entrant. Data Scientist, les compétences d’un projet Big Data. quoi le «Data Lake» ?

• L’intégration avec les anciennes données. • Comment dimensionner l’infrastructure et mesurer la scalabilité du sys-

• La qualité des données : un cinquième V ? tème ?

• Les différents types de traitement : recherche, apprentissage (machine • C’est quoi le cycle de vie d’un projet Big Data ?

learning, transactionnel, data mining). • Quelles sont les compétences nécessaires pour réussir dans la mise en

• D’autres modèles d’enchaînement : Amazon, e-Santé. place d’un projet Big Data ?

• Un ou plusieurs gisements de données ? De Hadoop à l’in-memory. • Comparaison des principales distributions d’Hadoop : Apache Hadoop vs

• De l’analyse de tonalité à la découverte de connaissances. HortonWorks vs Cloudera vs MapR

3. Relations entre Cloud et Big Data 2. Architecture Big Data

• Le modèle d’architecture des Clouds publics et privés. • Limites des architectures classiques

• Les services XaaS. • Avantages des nouvelles architectures Big Data

• Les objectifs et avantages des architectures Cloud. • Structures différentes de données (structurées, semi-structurées et non

• Les infrastructures. structurées)

• Les égalités et les différences entre Cloud et Big Data. • Stockage de grandes quantités de données à moindre coût et Scalabilité

• Les Clouds de stockage. en termes de stockage

• Classification, sécurité et confidentialité des données. • Performances élevées du traitement de données massives sous dif-

• La structure comme critère de classification : non structurée, structurée, férentes latences (Batch ou en Streaming) et scalabilité en termes de

semi-structurée. traitements

• Classification selon le cycle de vie : données temporaires ou perma- • Haute disponibilité

nentes, archives actives. • Agilité du système et son impact positif sur son évolution et sa mainte-

• Difficultés en matière de sécurité : augmentation des volumétries, la nance

distribution. • Impact sur l’entreprise et sa transformation en Client-Centric

• Les solutions potentielles. • Le Data Lake : une nouvelle philosophie pour le stockage et le traitement

4. Introduction à l’Open Data de la donnée

• La philosophie des données ouvertes et les objectifs. • Architecture du Data Lake et centralisation des données

• La libération des données publiques. • Cas d’usages basés sur le Data Lake

• Les difficultés de la mise en œuvre. • Le modèle « en couches » de données

• Les caractéristiques essentielles des données ouvertes. • Data Lake vs Data Warehouse

• Les domaines d’application. Les bénéfices escomptés. • La qualité de la donnée (Dataquality) dans un système Big Data

5. Matériel pour les architectures de stockage • Causes du problème de la qualité de données dans les systèmes Big Data

• Mise en place de la Gouvernance Applicative pour assurer la qualité des

• Les serveurs, disques, réseau et l’usage des disques SSD, l’importance de données

l’infrastructure réseau. • La qualité des traitements dans un système Big Data

• Les architectures Cloud et les architectures plus traditionnelles. • Importance de la supervision des chaînes de traitements

• Les avantages et les difficultés. • Exploitation efficaces des logs et détection des anomalies en temps réelle

• Le TCO. La consommation électrique : serveurs (IPNM), disques (MAID). • Mise en place de tableaux de bord pour la visualisation de la qualité des

• Le stockage objet : principe et avantages. traitements en temps réelle

• Le stockage objet par rapport aux stockages traditionnels NAS et SAN. • Types d’architectures Big Data selon les exigences temporelles

• L’architecture logicielle. • architectures Batch

• Niveaux d’implantation de la gestion du stockage. • Architectures Streaming

• Le «Software Defined Storage». • Lambda Architectures

• Architecture centralisée (Hadoop File System).

• L’architecture Peer-to-Peer et l’architecture mixte.

• Les interfaces et connecteurs : S3, CDMI, FUSE, etc.

• Avenir des autres stockages (NAS, SAN) par rapport au stockage objet.

160 FORMATIONS 2020 FORMATIONS 2020 161