Page 164 - CATALOGUE AGINIUS 2020

P. 164

IT - Big Data - Cybersécurité IT - Big Data - Cybersécurité

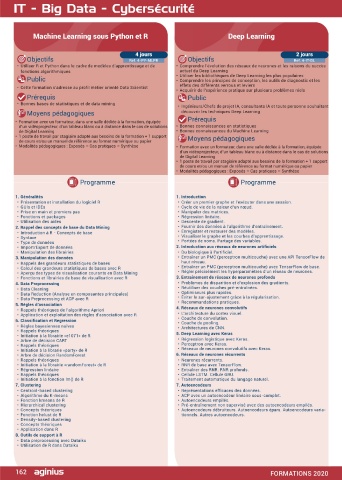

Machine Learning sous Python et R Deep Learning Data Scientist

4 jours 2 jours 5 jours

Objectifs Ref. 4-PY-MLPR Objectifs Ref. 4-IT-DL Objectifs Ref. 4-IT-DAS 8. Le Big Data

• Utiliser R et Python dans le cadre de modèles d’apprentissage et de • Comprendre l’évolution des réseaux de neurones et les raisons du succès • Savoir mettre en place un DataLake et un DataMart en SQL ou big data, • Qu’est-ce que Apache Hadoop ?

• Qu’est-ce que l’informatique distribué ?

fonctions algorithmiques actuel du Deep Learning puis une stratégie de Machine Learning en Python afin de créer le modèle • Installation et configuration de Hadoop

Public • Utiliser les bibliothèques de Deep Learning les plus populaires le plus satisfaisant possible en le mesurant et en affichant les résultats, le • HDFS

• Comprendre les principes de conception, les outils de diagnostic et les

• Création d’un datanode

tout en utilisant des algorithmes performants

• Cette formation s’adresse au profil métier orienté Data Scientist effets des différents verrous et leviers • Création d’un namenode distribué

• Acquérir de l’expérience pratique sur plusieurs problèmes réels Public • Manipulation de HDFS

Prérequis Public • Développeurs, chefs de projets proches du développement, ingénieur • Hadoop comme DataLake

• Bonnes bases de statistiques et de data mining scientifique sachant coder • Map Reduce

• Ingénieurs/Chefs de projet IA, consultants IA et toute personne souhaitant • Hive

Moyens pédagogiques découvrir les techniques Deep Learning Prérequis • Hadoop comme DataMart

• Python HDFS

• Formation avec un formateur, dans une salle dédiée à la formation, équipée Prérequis • Maîtriser l’algorithmique, avoir une appétence pour les mathématiques 9. Les bases de données NoSql

• La connaissance de Python et des statistiques est un plus

d’un vidéoprojecteur, d’un tableau blanc ou à distance dans le cas de solutions • Bonnes connaissances en statistiques • Les bases de données structurées

de Digital Learning • Bonnes connaissances du Machine Learning Moyens pédagogiques • SQL avec SQLite et Postgresql

• 1 poste de travail par stagiaire adapté aux besoins de la formation + 1 support Moyens pédagogiques • Les bases de données non ACID

de cours et/ou un manuel de référence au format numérique ou papier • Alternance entre apports théoriques et exercices pratiques Support de • JSON

• Modalités pédagogiques : Exposés – Cas pratiques – Synthèse • Formation avec un formateur, dans une salle dédiée à la formation, équipée cours fourni lors de la formation • MongoDB

d’un vidéoprojecteur, d’un tableau blanc ou à distance dans le cas de solutions • Cassandra, Redis, CouchDb

de Digital Learning Programme • MongoDB sur HDFS

• 1 poste de travail par stagiaire adapté aux besoins de la formation + 1 support • MongoDB comme DataMart PyMongo

de cours et/ou un manuel de référence au format numérique ou papier 10. Numpy et SciPy

• Modalités pédagogiques : Exposés – Cas pratiques – Synthèse 1. Introduction aux Data Sciences • Les tableaux et les matrices

• Qu’est que la data science ? • L’algèbre linéaire avec Numpy

Programme Programme • Qu’est-ce que Python ? • La régression linéaire SciPy Le produit et la transposée

• Qu’est que le Machine Learning ? • L’inversion de matrice

• Apprentissage supervisé vs non supervisé Les statistiques • Les nombres complexes

1. Généralités 1. Introduction • La randomisation • L’algèbre complexe

• Présentation et installation du logiciel R • Créer un premier graphe et l’exécuter dans une session. • La loi normale • Les transformées de Fourier Numpy et Mathplotlib

• GUIs et IDEs • Cycle de vie de la valeur d’un nœud. 2. Introduction à Python pour les Data Science 11. ScikitLearn

• Prise en main et premiers pas • Manipuler des matrices. • Les bases de Python • Régressions polynomiales

• Fonctions et packages • Régression linéaire. • Les listes • La régression linéaire

• Utilisation des aides • Descente de gradient. • Les tuples • La création du modèle

2. Rappel des concepts de base du Data Mining • Fournir des données à l’algorithme d’entraînement. • Les dictionnaires • L’échantillonnage

• Introduction à R - Concepts de base • Enregistrer et restaurer des modèles. • Les modules et packages • La randomisation

• Syntaxe • Visualiser le graphe et les courbes d’apprentissage. • L’orienté objet • L’apprentissage avec fit

• Type de données • Portées de noms. Partage des variables. • Le module math • La prédiction du modèle

• Import/Export de données 2. Introduction aux réseaux de neurones artificiels • Les expressions lambda • Les metrics

• Manipulation des librairies • Du biologique à l’artificiel. • Map, reduce et filter • Choix du modèle

3. Manipulation des données • Entraîner un PMC (perceptron multicouche) avec une API TensorFlow de • Le module CSV • PreProcessing et Pipeline

• Régressions non polynomiales

• Les modules DB-API 2 Anaconda

• Rappels des grandeurs statistiques de bases haut niveau.

• Calcul des grandeurs statistiques de bases avec R • Entraîner un PMC (perceptron multicouche) avec TensorFlow de base. 3. Introduction aux DataLake, DataMart et DataWharehouse 12. Nearest Neighbors

• Aperçu des types de visualisation courants en Data Mining • Régler précisément les hyperparamètres d’un réseau de neurones. • Qu’est-ce qu’un DataLake ? • Algorithme des k plus proches voisins (k-NN)

• Fonctions et librairies de base de visualisation avec R 3. Entraînement de réseaux de neurones profonds • Les différents types de DataLake • Modèle de classification

4. Data Preprocessing • Problèmes de disparition et d’explosion des gradients. • Le Big Data Qu’est-ce qu’un DataWharehouse ? • K-NN avec SciKitLearn

• Choix du meilleur k

• Qu’est qu’un DataMart ?

• Data Cleaning • Réutiliser des couches pré-entraînées. • Mise en place d’un DataMart • Sérialisation du modèle

• Data Reduction (Analyse en composantes principales) • Optimiseurs plus rapides. • Les fichiers • Variance vs Erreurs

• Data Preprocessing et ACP avec R • Éviter le sur-ajustement grâce à la régularisation. • Les bases de données SQL • Autres modèles : SVN, Random Forest

5. Règles d’association • Recommandations pratiques. • Les bases de données No-SQL 13. Pandas

• Rappels théoriques de l’algorithme Apriori 4. Réseaux de neurones convolutifs 4. Python Package Installer • L’analyse des données avec Pandas

• Application et exploitation des règles d’association avec R • L’architecture du cortex visuel. • Utilisation de PIP • Les Series

6. Classification et Regression • Couche de convolution. • Installation de package PIP PyPi • Les DataFrames

• Couche de pooling.

• Règles bayesiennes naïves • Architectures de CNN. 5. MathPlotLib • La théorie ensembliste avec Pandas

• Rappels théoriques 5. Deep Learning avec Keras • Utilisation de la bibliothèque scientifique de graphes MathPlotLib • L’importation des données CSV

• Initiation à la librairie «e1071» de R • Affichage de données dans un graphique 2D Affichages de sous-graphes • L’importation de données SQL

• Arbre de décision CART • Régression logistique avec Keras. • Affichage de polynômes et de sinusoïdales • L’importation de données MongoDB Pandas et SKLearn

• Rappels théoriques • Perceptron avec Keras. 6. Machine Learning 14. Le Clustering

• Initiation à la librarie «party» de R • Réseaux de neurones convolutifs avec Keras. • Regroupement des données par clusterisation Les clusters SKLearn

• Arbre de décision RandomForest 6. Réseaux de neurones récurrents • Mise en place d’une machine learning supervisé avec k-means

• Rappels théoriques • Neurones récurrents. • Qu’est qu’un modèle et un dataset • Autres modèles de clusterisation : AffinityPropagation, MeanShift, …

• Initiation à la librairie «randomForest» de R • RNR de base avec TensorFlow. • Qu’est qu’une régression • L’apprentissage semi-supervisé

• Régression linéaire • Entraîner des RNR. RNR profonds. • Les différents types de régression 15. Jupyter

• Rappels théoriques • Cellule LSTM. Cellule GRU. • La régression linéaire

• Initiation à la fonction lm() de R • Traitement automatique du langage naturel. • Gestion du risque et des erreurs • Présentation de Jupyter et Ipython

7. Clustering 7. Autoencodeurs • Quarter d’Ascombe • Installation

• Utilisation de Jupyter avec Mathplotlib et Sklearn

• Trouver le bon modèle

• Centroid-based clustering • Représentations efficaces des données. • La classification 16. Python Yield

• Algorithme du K-means • ACP avec un autoencodeur linéaire sous-complet. • Loi normale, variance et écart type

• Fonction kmeans de R • Autoencodeurs empilés. • Apprentissage • La programmation efficace en Python

• Hierarchical clustering • Pré-entraînement non supervisé avec des autoencodeurs empilés. • Mesure de la performance No Fee Lunch • Le générateurs et itérateurs

• Concepts théoriques • Autoencodeurs débruiteurs. Autoencodeurs épars. Autoencodeurs varia- 7. La régression linéaire en Python • Le Yield return

• Fonction hclust de R tionnels. Autres autoencodeurs. • Le Yield avec Db-API 2, Pandas et Sklearn

• Density-based clustering • Programmer une régression linéaire en Python 17. Les réseaux neuronaux

• Concepts théoriques • Utilisation des expressions lambda et des listes en intention Afficher la • Le perceptron

• Application dans R régression avec MathPlotLib • Les réseaux neuronaux

8. Outils de support à R • L’erreur quadratique • Les réseaux neuronaux supervisés

• La variance

• Data preprocessing avec Dataiku • Le risque • Les réseaux neuronaux semi-supervisés

• Utilisation de R dans Dataiku • Les réseaux neuronaux par Hadoop Yarn

• Les heuristiques

• Le deep learning

162 FORMATIONS 2020 FORMATIONS 2020 163